全球视野下的未成年人网络保护:规制图谱与趋势洞察

全球视野下的未成年人网络保护:规制图谱与趋势洞察

近年来,全球未成年人网络保护监管进入“强执法时代”。各国监管力度层层加码,违规处罚案例密集曝光,互联网企业因身份验证流于形式、防沉迷机制失效和数据隐私漏洞等问题被调查追责的情况屡见不鲜。2023年9月,TikTok因违反GDPR儿童个人数据保护规定,以及年龄验证机制不足等被处以3.45亿欧元罚款;2024年2月,TikTok因未成年人成瘾设计被欧盟委员会启动执法调查;2025年1月,米哈游因违反《美国联邦贸易委员会法》和《儿童在线隐私保护法》向美国执法机构支付2000万美元和解金;2024年11月,快手因落实青少年模式不到位,被我国公安机关给予行政处罚。

由此可见,如何守住未成年人保护的合规红线,已成为企业在国内运营不踩雷、出海展业不碰壁的一项关键命题。有鉴于此,本文将以全景图的方式系统性拆解未成年人网络保护的核心监管要点,定位企业易踩的合规风险,并针对性给出国内合规落地与跨境业务适配的实务路径,助力企业提前构建合规防线,降低违法风险。

一、未成年人在网络生态中面临的风险及未成年人保护的全球行动

当前未成年人网络生态中,沉迷网络游戏与短视频、接触淫秽色情暴力等违法不良信息、被诱导消费、个人隐私泄露等风险持续存在。与此同时,网络欺凌、AI滥用等新问题也逐步凸显,这些都对未成年人的健康成长构成威胁。

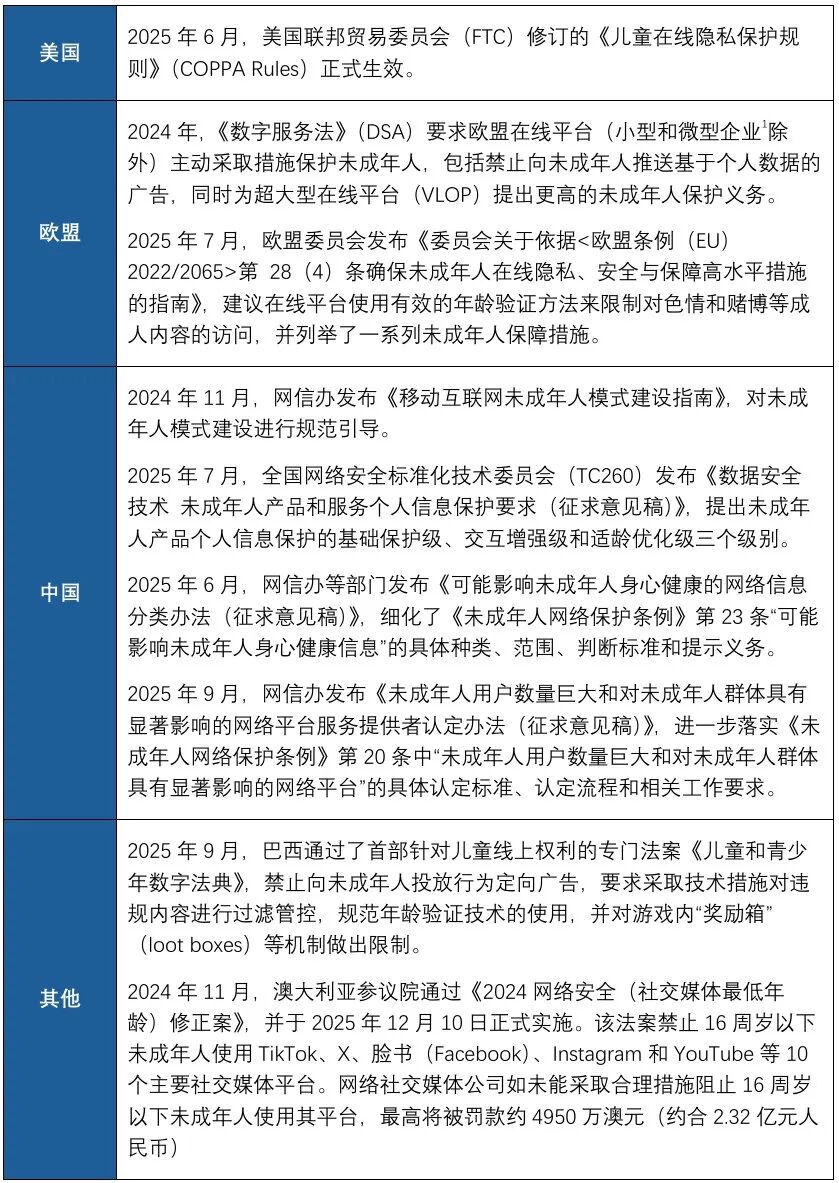

针对以上风险,各国监管机关制定了多项针对互联网企业的合规要求。以下是近年来,美国、欧盟以及中国等法域对未成年人网络保护采取的主要立法行动概览:

点击可查看大图

二、未成年人网络保护监管关注重点问题

结合未成年人网络风险与各国当前的监管思路来看,近年来未成年人网络保护的监管关注重点问题集中在身份验证、内容管理、广告治理、隐私保护、AI合规以及大型网络平台责任几个方向。

1、身份验证

在网络世界,要保护未成年人,首先得先识别未成年人。欧盟DSA明确要求对成人内容(如色情、赌博)实施严格的年龄验证,DSA配套指南也强调不得使用不合理或无效的年龄验证工具。我国《未成年人保护法》指出,网络游戏服务提供者与网络直播服务提供者应对未成年人身份予以核验。今年6月,美国联邦最高法院维持了德克萨斯州的一项法案,该法案要求含大量成人内容的网站在授予访问权限前验证用户年龄。

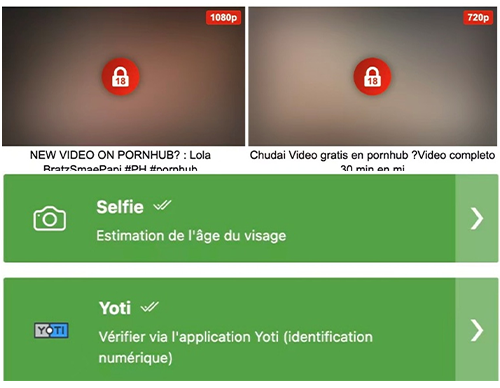

根据可靠性的不同,身份验证机制可分为自我声明年龄验证、知识型验证、支付关联验证、身份证件验证、人脸生物特征验证、移动网络运营商辅助验证以及网络数字身份验证等方式。当涉及不宜儿童访问的内容或功能时,仅自我声明式的年龄验证很可能被视为无效验证。因此,当前世界各国的监管趋势是要求企业针对敏感的功能模块选取可靠性更高的验证方式,而非仅依赖于用户对于年龄的自我声明。例如,社交平台X会对包含暴力、色情等元素的敏感图片施加访问权限控制,仅在特定验证通过后可查看(如下图)。谷歌表示[2]将在美国使用人工智能技术估算用户年龄,基于用户的搜索历史、观看偏好、账户时长、设备行为等系列行为数据来推断用户是否已满18周岁,若系统判断为未成年人账户,将自动启用青少年模式。

图示:敏感图片访问权限控制及身份验证机制

2、内容管理

在内容管理上,世界各国监管机构均要求企业向未成年人屏蔽展示违法违规和有不良价值导向的内容。

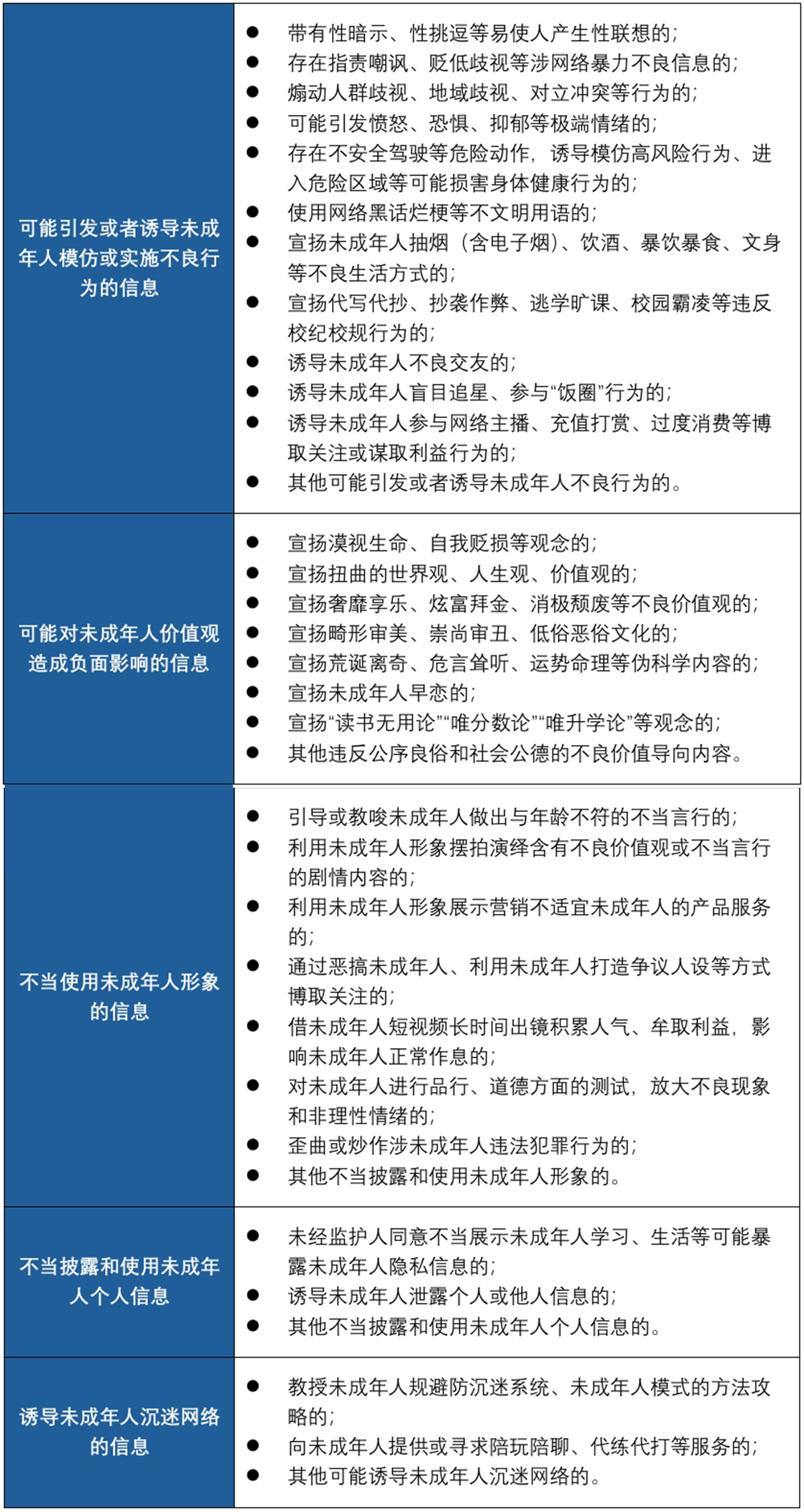

欧盟2018年更新了《视听媒体服务指令》(Audiovisual Media Service Directive,AVMSD),除禁止儿童色情内容外,还规定视听媒体中不得包含煽动暴力、仇恨、歧视(包括但不限于年龄、性取向、残疾等)、恐怖主义、种族主义、仇外心理、破坏环境以及其他可能损害儿童身心健康的信息。我国也已制定《网络信息内容生态治理规定》,并于2025年6月出台了《可能影响未成年人身心健康的网络信息分类办法(征求意见稿)》,明确提出不得在专门以未成年人为服务对象的网络产品和服务中或在首页首屏、弹窗、热搜、榜单、推荐、精选等处于产品或者服务醒目位置、易引起用户关注的重点环节去呈现可能影响未成年人身心健康的网络信息(如下图),同时要求为用户提供添加显著提示效果的标识功能,引导和规范用户对可能影响未成年人身心健康的网络信息作出显著提示。

点击可查看大图

3、互联网广告治理

在广告营销领域,各国监管机构对于广告发布者或广告主也提出了一系列未成年人保护要求,例如:

首先,部分广告类型不得向未成年人推送。例如,我国《广告法》第40条与《互联网广告管理规定》第12条均规定了在针对未成年人的互联网媒介上不得发布特定领域的广告。不少境外互联网平台,如谷歌,也已专门制定不宜向未成年人投放的广告内容清单。

其次,要求企业在选择广告代言人时注意未成年人保护。例如,根据我国《广告法》《关于加强网络直播规范管理工作的指导意见》和《关于规范网络直播打赏加强未成年人保护的意见》等要求,不得利用不满10周岁的未成年人作为广告代言人,不得利用未满16周岁的未成年人作为直播营销人员,利用16至18周岁的未成年人作为网络直播营销人员,应征得监护人同意。

最后,我国监管机构还限制面向未成年人推送个性化推荐广告的行为。我国《未成年人网络保护条例》第24条要求,网络产品和服务提供者不得通过自动化决策方式向未成年人进行商业营销。典型的场景包括收集未成年人的性别、年龄、兴趣爱好等个人信息以及未成年人在设备上使用产品、浏览内容和点赞内容等,并通过计算机的算法等自动处理来预测未成年人用户的广告偏好并向其投放个性化广告(含搜索广告结果排名)。类似地,欧盟GDPR也明确禁止对儿童进行用户画像。

4、隐私保护

欧盟、美国以及中国均将儿童个人信息视为一种特殊的信息类型,需履行更加严格的合规义务。例如:

一方面,对于获取数据主体的同意,欧盟要求处理未满16岁(各成员国可以根据具体情况在国内法中设定更低的年龄限制,但不得低于13岁)未成年人的个人数据必须取得其父母或监护人的同意,美国要求处理未满13周岁未成年人的个人数据必须取得其家长的可验证同意,我国同样要求处理未满14周岁的未成年人个人信息应取得其父母或其他监护人同意。

另一方面,对于企业的内部合规机制,我国《未成年人网络保护条例》第37条规定,个人信息处理者应当自行或者委托专业机构每年对其处理未成年人个人信息遵守法律、行政法规的情况进行合规审计,并将审计情况及时报告网信等部门。相较于《个人信息保护合规审计管理办法》的规定(处理超过1000万个人信息应每两年至少开展一次审计),建议处理未成年人个人信息的企业将开展审计的频次适度提高一些。

5、AI应用中的未成年人保护

随着AI迅猛发展,许多企业在业务和产品中开始部署大模型或集成AI功能。人工智能生成合成内容(AIGC)作为数字时代的新型信息载体,也应当将未成年人保护原则深度嵌入技术架构与运营的全流程。在输入端口,预训练或优化训练大模型时,应确保涉及未成年人的数据来源合法合规,剔除涉及危害未成年人身心健康的违法违规语料。在输出端口,一方面企业有必要持续迭代大模型的内容过滤算法,精准识别并阻断暴力、恐怖、色情等有害元素的生成,防范AI通过“隐喻表达”“模糊暗示”等隐蔽方式传播错误价值观,另一方面,企业宜合理规范AI聊天机器人与未成年人的交互,提示未成年人在家长等监护人的监督下使用AI,并采取一定手段避免未成年人对AI功能沉迷上瘾、避免AI幻觉现象使得未成年人轻易误信AIGC内容,以及避免未成年人过度依赖AI。

6、大型网络平台监管

从国际到国内,大型网络平台的未成年人保护责任正在被持续强化。欧盟DSA明确对掌握海量用户与流量的“守门人”平台提出更高阶的保护要求,我国《未成年人网络保护条例》同样针对未成年人用户规模庞大、对未成年人有显著影响的大型网络平台,增设了额外合规义务,例如要求设立未成年人网络保护合规制度体系、定期开展未成年人网络保护影响评估、每年发布未成年人网络保护社会责任报告等。由此可见,大型网络平台作为未成年人线上活动的核心聚集地,承载着更关键的保护角色,也被赋予了更多的合规责任。

在我国,根据2025年9月16日发布的《未成年人用户数量巨大和对未成年人群体具有显著影响的网络平台服务提供者认定办法(征求意见稿)》,符合以下情形之一的,应当认定为未成年人用户数量巨大的网络平台服务提供者:

① 该网络平台提供的产品或者服务专门以未成年人为服务对象,注册用户在1000万以上或者月活跃用户在100万以上;

② 该网络平台提供的产品或者服务的对象不局限于未成年人的,未成年人注册用户数量在1000万以上或者月活跃未成年人用户在100万以上。

在认定是否属于对未成年人有显著影响的网络平台服务提供者时,则应当综合考虑该网络平台的未成年人登录频次、使用时长、喜爱程度、消费金额等指标,该网络平台是否涵盖大量涉及或面向未成年人的信息内容以及该网络平台在3年内是否存在较多涉未成年人突出情况等因素。

征求意见稿指出,未成年人用户数量巨大的网络平台服务提供者的认定工作原则上每3年开展一次,也可在出现用户数量激增、对未成年人影响显著提升、社会广泛关注等情形时启动。因此,无论是主打未成年人市场的教育、娱乐类平台,还是用户群体覆盖全年龄段但未成年人占比较高的社交、内容类平台,或是智能终端生产销售企业与互联网新技术研发机构,均可对照上述量化标准主动开展用户数据自查,统计未成年人注册量与月活数据,判断是否可能被纳入“重点监管平台”范畴。对于接近或已达到认定标准的企业,更应提前启动合规预备动作。

三、企业未成年人保护合规路径

面对全球趋严的监管态势与细化的合规要求,企业需将未成年人网络保护融入业务全流程,通过体系化建设构建长效合规机制。具体而言,我们建议企业从以下维度推进:

1、健全流程制度管理,夯实合规基础

企业可结合自身业务属性与监管要求,搭建未成年人保护制度体系。一方面,企业需明确内部各部门的合规职责,例如由法务或者合规部门牵头制定《未成年人网络保护专项合规手册》等指南文件,细化身份验证、内容审核、隐私保护等环节的操作标准;由产品研发部门负责将合规要求嵌入功能设计,由运营部门落实日常监测与应急处置,形成“权责清晰、协同联动”的管理流程。另一方面,企业需建立动态更新机制,定期跟踪国内外立法动态(如海外法规的配套指南、我国征求意见稿落地情况等),及时调整制度条款,确保合规要求与监管同步,避免因制度滞后引发风险。

2、强化产品上线审核,前置风险防控

企业应考虑将未成年人保护纳入产品全生命周期管理,在上线前完成合规评估与风险排查。产品规划阶段,需针对目标用户群体(尤其是可能覆盖未成年人的场景)开展专项评估,判断是否需要设置未成年人模式、年龄验证等功能;研发阶段,需对照监管要求优化设计,例如规避易引发沉迷的功能,确保内容推荐算法符合监管要求;上线前审核阶段,需组建跨部门评审小组对产品的身份验证机制、内容过滤能力、隐私保护措施等进行全面测试,从源头阻断风险。

3、开展定期风险筛查,动态监控隐患

建议企业建立常态化风险筛查机制,及时识别并处置合规漏洞。一方面,定期开展内部自查,结合监管重点、执法动向以及典型案例,对身份验证有效性、内容审核准确率、广告投放合规性、个人信息保护情况等进行全面检查,例如每季度核查未成年人用户数据统计是否准确、敏感内容过滤是否存在遗漏,每年对照最新法规开展一次全面合规审计;另一方面,加强外部风险监测,通过关注监管部门通报、行业动态、用户投诉等信息,及时发现潜在风险点,动态调整筛查维度与技术手段,确保风险早发现、早处置。此外,企业可借助技术工具提升合规效率,例如利用AI算法辅助识别不良内容,也可以对接专业法律服务机构,获取法规解读、合规培训、风险评估、合规差距分析及整改优化等支持。

四、结语

对于企业而言,未成年人网络保护从来不是“成本负担”,而是赢得社会信任、实现长远发展的“隐形资产”。将合规要求融入业务全流程,把保护措施落进产品每一个细节——这不仅是在全球未成年人网络保护监管要求不断趋严的态势下,企业管控监管风险的明智之选,也是企业切实履行社会责任、以实际行动践行守护下一代的必然选择。

[注]

[1]根据DSA,小型和微型企业是指雇用少于50人且年营业额低于1000万欧元的机构。

[2]https://www.theverge.com/news/716154/google-ai-age-estimation-under-18.