数字出海合规启示录(二):当年龄保障成为出海企业的关键合规挑战

数字出海合规启示录(二):当年龄保障成为出海企业的关键合规挑战

一、引言:信息社会未成年人保护的趋势和固有困局

几乎所有未成年人保护制度——无论是儿童个人信息处理需经监护人同意、禁止对未成年人进行画像广告,还是内容分级与风险控制——都建立在一个前提之上:平台能够识别用户年龄。

识别年龄这一话题在海外市场面临隐私保护、言论自由等多种价值的冲击,加之用户转化率和成本等商业化考量,一直是平台合规领域的痛点。但在实践中,长期依赖用户自我声明或事后纠偏的路径,已难以回应未成年人风险的现实规模与社会关切。在此背景下,这一前提正在被各国立法从“合规假设”转化为“强制义务”。2025年12月 10日,澳大利亚关于《Online Safety Act 2021》的修订案正式生效,首次以全国性立法形式对16岁以下社交媒体账户设立强制性最低年龄门槛(SMMA)[1];挪威、丹麦、马来西亚等国亦已启动或公开讨论类似制度[2]。监管重心正从形式化的“自我声明”,转向“是否具备可信、可审计的年龄保障能力”。

这一趋势并非孤立出现,而是源于网络与AI技术加速发展背景下未成年人风险的系统性放大——包括网络霸凌、诱骗、有害或色情内容暴露、成瘾性设计以及个人数据滥用等,甚至危害青少年的生命安全[3]。各国监管机构因此在数据保护与内容安全两个维度同步加码,并逐步将责任前移至平台入口环节。

对中国出海互联网企业而言,“年龄保障”正在从合规附加项演变为进入和持续经营关键市场的前置条件。在社交、内容、游戏、AI互动类产品中,若仍主要依赖用户自我声明或协议排除等“形式合规”路径,不仅难以满足新一轮监管要求,也将直接影响产品上架、渠道合作与市场准入。

二、基本概念、法律基础与责任分配

涉及网络社会的未成年人保护,实际上有三种类型的服务:1. 绝对禁止:线下就严格禁止向未成年人提供服务的线上延伸,例如赌博、色情、酒精、烟草、危险产品等;2. 严格限制:并未直接限制向未成年人提供,但因其内容传播、算法推荐或互动机制存在显著风险,监管重点在于系统性风险治理,主要包括内容平台、在线社区、搜索引擎,社交软件等,核心监管要求来源于内容监管和数据保护,通常包括未成年人风险评估、内容分级与过滤、防沉迷设计、互动安全与算法约束;3. 一定限制:不属于也未包含前述服务特质,主要要求在于监管人同意,禁止个性化广告和画像等,核心监管要求来源于强化的未成年人数据保护,此种情况包含了儿童受众产品和混合受众产品,是覆盖面最广的服务类型,常见的游戏、学习工具、会议、导航、运动、物联网等可能都会落入这一类范围。但需要注意的是,若该类服务叠加社区、聊天或公开互动等功能,则可能因具备第二类的风险特征而同时适用更高强度的合规要求。这三类服务在年龄保障措施验证的强度上也有显著差异。

(一)概念区分:年龄保障与年龄验证

在国内,由于存在实名制的要求,通过通讯运营商或者身份证验证等方式能够明确识别用户的具体年龄,结果相对准确,实际上属于年龄验证。而在海外,由于并不存在通行的实名制要求,网络服务提供方往往采取自我申报、邮件验证的做法,实际上属于年龄保障(Age Assurance)机制。

1、年龄保障(Age Assurance)

英国信息专员办公室(Information Commissioner’s Office,"ICO")在《Age assurance for the Children’s Code》(《儿童规范中的年龄保障意见》)中,将“年龄保障”定义为一组用于估算或确认用户年龄的方法组合,可包括自报年龄、行为/设备信号分析、第三方验证以及生物特征估算等,重点在于“适当且相称(necessary and proportionate)”[4]。

欧盟DSA (“Digital Service Act”)的相关指南同样使用“age assurance”概念,强调平台应根据孩子实际接触的风险场景,选择准确、可靠、稳健且尽量不侵入隐私的年龄保障方法。目前在线平台最常用的年龄保证措施可分为三大类:自我声明、年龄估算和年龄验证。

自我声明是指依靠个人提供年龄或确认年龄范围的方法,可以通过自愿提供出生日期或年龄,或者通过在线点击按钮声明自己已超过某个年龄。

年龄估计包括允许提供者确定用户可能达到某个年龄、属于某个年龄范围或超过或低于某个年龄的方法。

年龄验证系统依靠物理标识符或经过验证的身份证明来源,能够高度确定用户的年龄。

年龄估算和年龄验证的主要区别在于准确度。年龄验证能够提供用户年龄的确切信息,而年龄估算则只能提供用户年龄的近似值。年龄估算技术的准确度会随着技术进步而提高,并且可能存在差异。[5]

2、年龄验证(Age Verification)

在多数法规和监管文件中,年龄验证通常指通过官方身份凭证、支付工具或可信数据库,对用户年龄进行相对刚性的确认。典型方式包括:上传身份证件、使用银行卡/信用卡验证、依托政府电子身份或电信实名信息等。

简言之:年龄验证是年龄保障中的“强硬一端”,年龄保障则是基于风险的整体方案。

3、年龄保障的基本原则

DSA相关指南中说明,平台提供商应考虑年龄保障的措施的适当性和相称性,包括以下原则:

*准确度。指任何给定方法确定用户年龄的准确程度。

*可靠性。指某种方法在实际应用环境中可靠的程度。

*稳健性。指绕过某种方法的难易程度。

*非侵入性。某种方法对用户权利的侵入程度如何。

*非歧视原则。某种方法如何可能对某些用户构成歧视。

委员会认为,自我声明不符合上述所有要求,特别是稳健性和准确性的要求。因此,委员会认为自我声明并非确保未成年人隐私、安全和保障的适当年龄保证方法。[6]澳大利亚社交媒体禁令亦认为平台需采取合理步骤和多种方式来识别用户年龄,不能仅依赖自我申报,也不应强制要求用户提供身份证件作为唯一验证方式。[7]

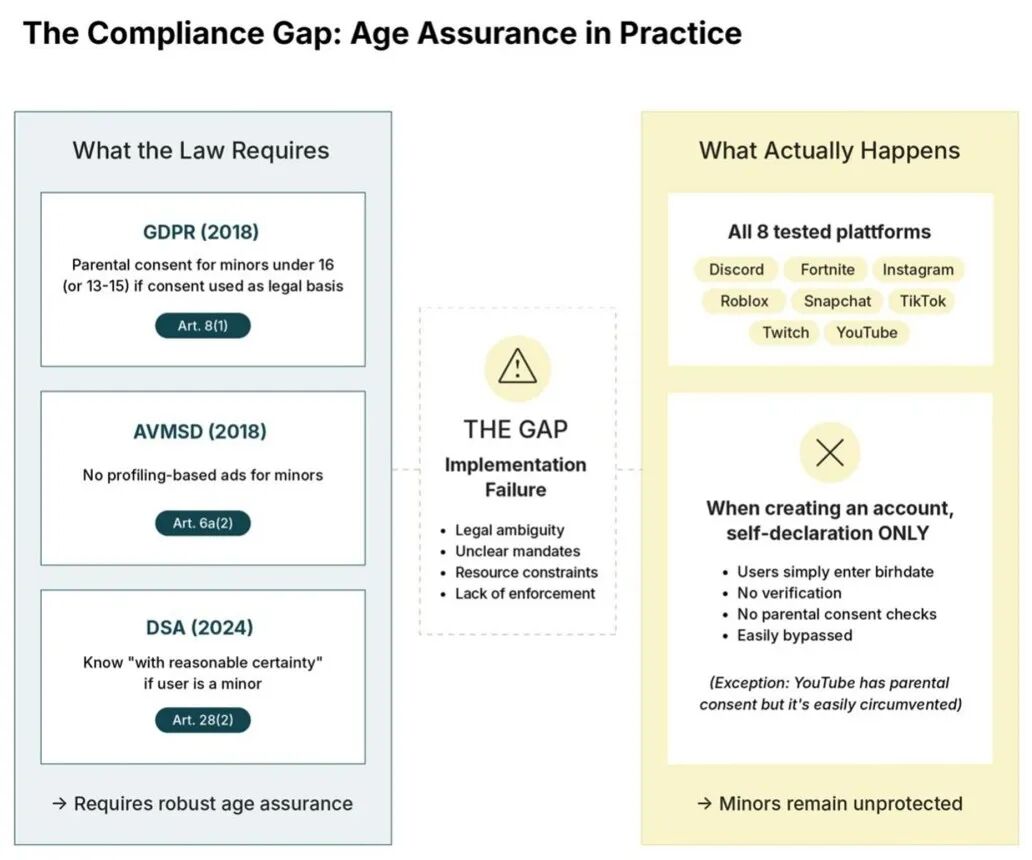

然而,实证研究表明,多家平台企业均采取自我声明为主的验证方式,导致具体合规义务的落实存在显著差异,这也是这几年欧盟监管机构加强相关措施的一定诱因。

来源:Mind the Gap: Age Assurance and the Limits of Enforcement under EU Law[8]

(二)法律基础:数据保护与内容监管的基本要求和困局

对于海外在线服务未成年人保护相关的规定进行总结,通常集中在数据保护和内容监管两个维度,以系统化立法为代表的欧盟,和2025年未成年人保护进一步发力的美国为例,主要法规核心要求和困局总结如下:

1、欧盟

A. GDPR项下的基本数据保护制度

GDPR项下,关于儿童在信息社会服务方面同意的适用条件的第8条规定,当以同意作为收集和处理个人数据的法律依据时,控制者必须知悉其用户是否超过或低于16岁(或最低不低于13岁,具体取决于成员国)。

这里揭示了一个重要的法律漏洞:上述内容仅在收集和处理个人数据的法律依据是数据主体的同意时才有效。然而,数据控制者完全可以选择其他法律依据来收集和处理未成年人的个人数据,例如履行合同、法律义务或自身的合法利益。控制者可以在广告个性化、反欺诈、服务提供等场景尝试“履行合同”“合法利益”等其他法律基础;事实上,对于广告等敏感处理活动的合法基础论证存在很多争议。

B. DSA和《视听媒体服务指令》(AVMSD)项下的内容监管制度

DSA要求对可被未成年人访问的平台进行系统性风险评估,覆盖内容、行为、接触、消费和交叉风险五大类别。关于年龄保障,DSA第28条第1款强制要求“未成年人可访问的在线平台”(即未成年人可能访问的社交媒体、市场和视频分享平台)采取“适当且相称”的措施确保未成年人的高隐私与安全;不得基于个人数据向“已知为未成年人”的用户展示定向广告;但同时明确第28(3) 条:平台不应因评估是否未成年人而被迫处理额外的个人数据。

以上条款体现欧盟监管机构既希望平台进行有效年龄保障(age assurance);又限制平台处理更多个人数据,使实际准确识别未成年用户变得困难,留下可规避空间。(后续的欧委会指南虽做解释,但并无强制性效力。)

《视听媒体服务指令》(Audiovisual Media Services Directive, AVMSD,以下称“《AVMS指令》”)对欧盟范围内的视听媒体进行监管。它适用于传统电视广播公司(“线性服务”)、点播服务(例如流媒体平台,如Netflix)以及视频分享平台(例如YouTube)。《AVMS指令》第6a 条规定了对未成年人的具体保护措施。[9]要求采取年龄保障措施,确保能够明确区分成年人和未成年人,保护未成年人免于接触不适宜的内容;不得将未成年人个人数据用于商业目的。但是,《AVMS指令》的保护力度相对没有GDPR和DSA有力:首先,它的适用范围有限;其次,由于它的指令身份,其效力依赖成员国转置,导致保护标准不一。

最后,由于数字服务的多元化情况,欧盟整体和各成员国的立法状况亦参差不齐。具体成员国中,可能由数据保护机构、电信监管机构、媒体监管机构、消费者保护机构等分别管辖。再加上执法资源有限,导致:监管责任分散;执行不充分;跨机构协作(国家层面和欧盟层面)不足,使得欧盟“高标准立法—低一致性执法”的问题在未成年人保护议题上更加突出。这些情况导致未成年人保护的执法效果无法得到充分保障。

2、美国

在美国联邦层面,未成年人在线保护的基础性制度仍然是《儿童在线隐私保护法》(Children’s Online Privacy Protection Act, "COPPA"),该法要求面向 13 岁以下儿童的网站和在线服务在收集个人信息前必须取得“可验证的家长同意”(verifiable parental consent, "VPC"),并在 COPPA 规则(16 CFR Part 312)中明确列举多种可接受的验证方式,包括信用卡或借记卡扣款验证、政府身份证件比对、由受控的电话或视频会话完成身份确认、以及经FTC批准的其他第三方身份核验方法。[10]随着FTC于2024年初发布《COPPA 安全港修订规则》,监管要求已进一步强化,特别是对安全港机构实施更高强度的透明度、年度审查与违规报告义务,使COPPA 的执行从传统的“事前提交与自律”为主,转向“持续审查与监管介入”模式,并成为2025年后 COPPA强化改革(俗称COPPA 2.0)之前的过渡性制度基础。

然而,与欧盟以GDPR和DSA为代表的统一化体系不同,美国的监管结构呈现高度碎片化,各州的综合隐私法(如加州CCPA/CPRA、科罗拉多 CPA、康涅狄格CTDPA)[11]、适龄设计规范、网络安全法、社交媒体保护法以及成瘾性信息流管制法共同构成企业必须面对的监管拼图。这些法律往往扩展了联邦COPPA未覆盖的年龄段,例如禁止对13–16岁未成年人进行画像广告,要求平台对未成年用户默认提供更高隐私设置,或在处理未成年人敏感数据时必须取得“积极授权”(opt-in consent)。[12]美国多个州亦在 2023–2025年间通过“未成年人社交媒体使用法”“成瘾算法限制法”等新立法,要求平台提供家长控制、限制夜间推送或要求关闭推荐算法,对平台的产品设计和风险管理提出更具体义务。[13]

在内容监管与年龄访问控制方面,多州已通过专门法律要求社交媒体和成人内容平台实施强制年龄验证,甚至将义务延伸至应用商店。例如路易斯安那州、犹他州、阿肯色州等要求上传政府ID 或使用州认可的年龄验证服务,未成年人须经父母许可方可注册社交媒体或访问高度敏感内容。然而,这类法律在实践中迅速引发合宪性争议,并在多个联邦法院被暂缓执行。典型案例包括 NetChoice v. Griffin(阿肯色州社交媒体年龄验证法被联邦法院裁定可能违反第一修正案的言论自由保障)[14]、NetChoice v. Paxton(德州社交媒体限制法因涉及内容访问与平台编辑权而受限)[15]以及 Free Speech Coalition v. Paxton 系列案件(成人内容网站年龄验证法因可能构成对匿名表达的过度限制而受到挑战)[16]。这些案例反映出美国在未成年人保护领域面临的结构性难题:一方面,立法者和公众普遍期待加强对未成年人的在线安全保护;另一方面,强制年龄验证、算法限制及内容访问限制又可能触及第一修正案确立的言论自由与匿名权,导致“合规期待与合宪性争议并存”的制度困境,使企业必须在高度不确定的法律环境中寻求动态合规策略。

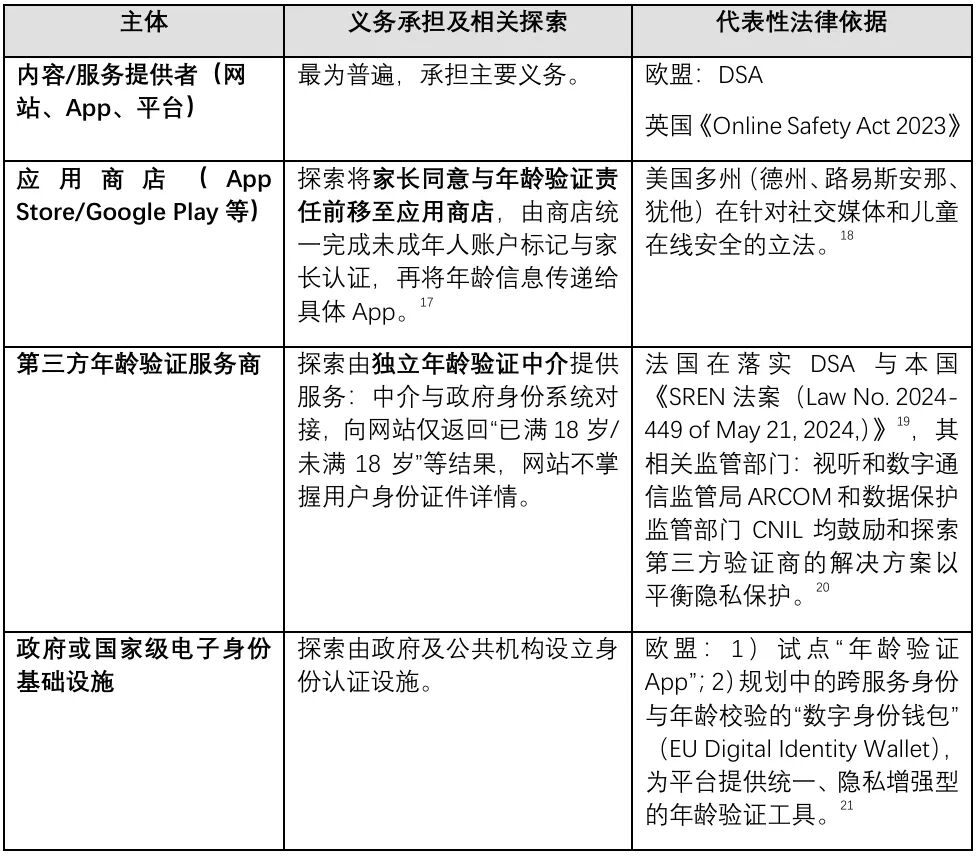

(三)责任主体和实施路径

1、责任主体

实践中,“谁要负责年龄验证/保障”已经不再局限于App本身,而呈现多主体分担模式:

点击可查看大图

对出海企业而言,合规问题已不再是“单一App是否做了年龄验证”,而是要搞清楚:在某一法域下,自己是直接责任主体、依赖应用商店,还是接入政府/第三方基础设施,并据此安排合同、隐私政策与证据留存。

2、实施路径

年龄验证的实施方式多种多样,包括开发内部系统、使用第三方服务提供商、由可信成年人验证未成年用户的年龄,以及依赖其他服务提供商在设备、操作系统、浏览器和平台层面提供的年龄验证服务。即将发布为国际标准ISO/IEC 27566-1的年龄验证系统框架,详细阐述了不同的年龄验证方法以及隐私和安全方面的考量。[22]

综合各法域监管文件,可将年龄保障技术和流程大致分为三层:

1、注册与登录阶段的年龄门槛

*基础层:自报年龄、日期校验;

*加强层:交叉比对设备/账户信息、行为特征等软信号;

*在高风险服务或特定年龄段,可在注册阶段引导至应用商店或第三方验证服务商做强验证。[23]

2、高风险功能前的“闸门

对成人内容、赌博、开放匿名聊天、付费打赏等高风险功能,欧美监管普遍要求在功能入口前叠加强度更高的年龄验证手段,例如:身份证件验证、银行卡验证、电信运营商KYC或政府eID。[24]

3、后台治理与持续监测

在DSA指南和Ofcom指引中,年龄保障并非一次性动作,而要与风险评估(risk assessment)、内容审核、算法调整和投诉响应机制结合,通过行为监测发现疑似未成年人账户并触发额外保护。[25]

三、合规操作框架:普适基线与法域调试

在上述法规与趋势基础上,出海企业在设计年龄保障与未成年人保护机制时,可以区分“普适合规基线”与“根据法域进行差异化调试的关键点”进行综合合规框架设计。

(一)普适基线:产品定位和年龄分组

1、产品层面:识别被未成年人使用的高风险功能

首先,结合产品定位,定位属于儿童向产品(child-directed services)[26]、混合受众产品(mixed-audience services)[27]还是成人向产品(adult-only services)[28]并酌情采取相适应的年龄保障措施。在监管视角中,近年来的重点已从“纯儿童向”扩展到混合受众平台——即便企业并不以儿童为主要目标人群。

其次,对于混合受众产品而言,定位高风险功能采取强化验证措施,参考DSA指南和新加坡 PDPC指引,应将成人内容、赌博、开放匿名聊天、AI生成敏感内容、打赏等功能列入“高风险功能清单”,即便整个平台定位并非儿童向,只要“可能被未成年人访问”,相关功能就须进行额外保护。[29]

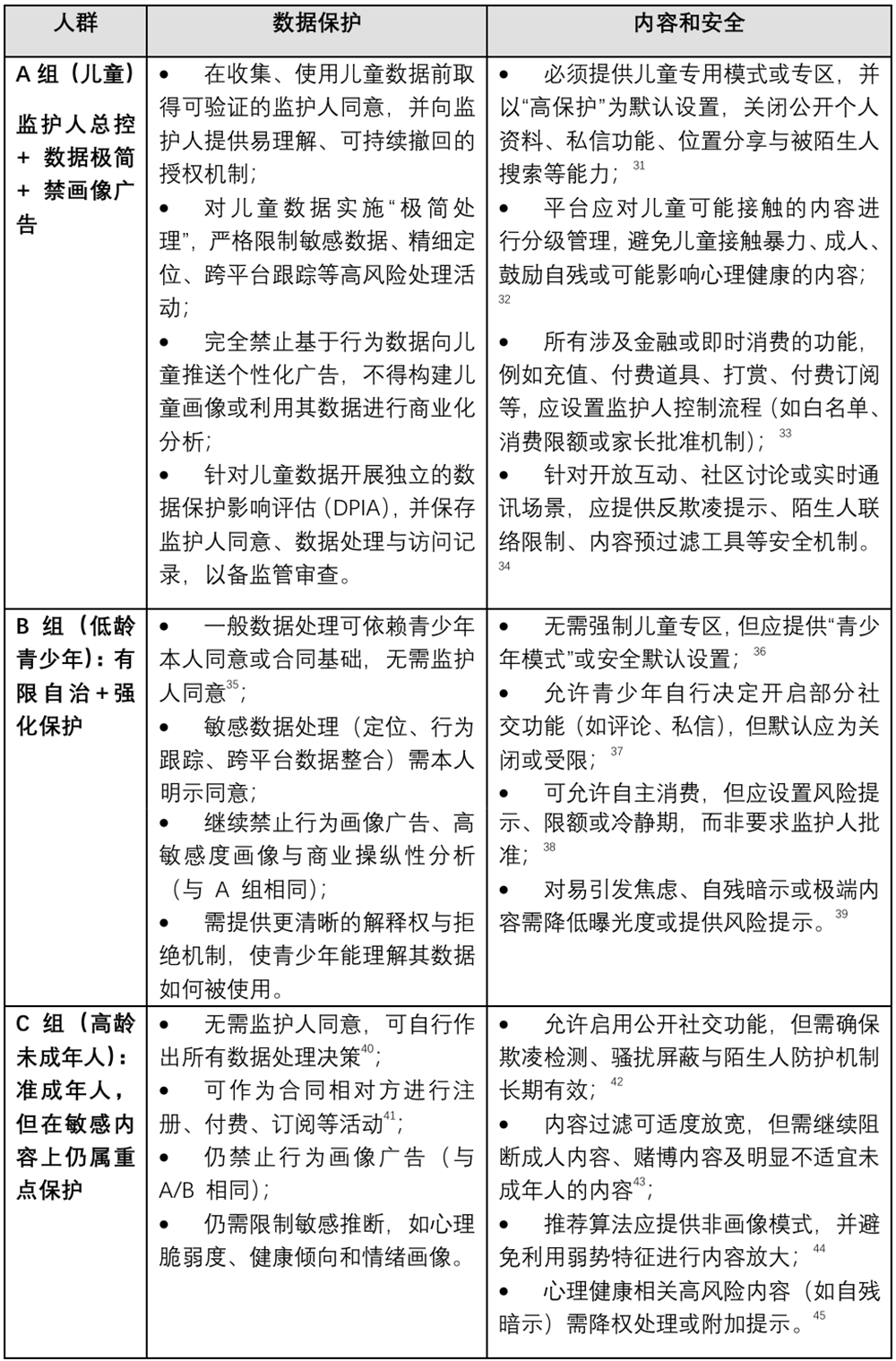

2、年龄分组:分组分级控制强度并配套流程保障

通过内部统一将用户分为儿童、低龄青少年和高龄未成年人三组,分别配套“强监护人控制+禁画像广告”“部分自决+强干预”“接近成年人但敏感内容强化管控”三套控制工具箱,再根据各法域对儿童/未成年人的年龄定义调整边界,可在多法域环境下维持整体一致性。初步分组如下:

A组:儿童(约0–12/13岁以下)

B组:低龄青少年(约13–15/16岁)

C组:高龄未成年人(约16–17岁)[30]

在此基础上,可对应不同的“合规模式”,其中数据保护的要求来源于GDPR等数据保护法律框架,儿童被视为最需要强化保护的群体,各国均通过年龄门槛与监护人机制对儿童数据处理设置更严格要求。内容管理和安全保护的要求主要来自于欧盟DSA、英国儿童适龄设计规范(AADC)、美国部分州的社交媒体法与平台治理实践。总结重点措施如下:

点击可查看大图

(二)法域调试点一:年龄定义与法律地位差异

不同法域对儿童和未成年人的年龄界限不同[46],会影响同意有效性、可执行功能及监管期待。对企业而言,更稳健的做法是在内部采取偏保守的年龄分群,再按当地法律做局部放宽,而非在不同法域采用完全割裂的年龄逻辑。

(三)法域调试点二:责任链条前移或分担

第二个需要“调校”的点是责任链如何安排:在服务提供方承担直接责任的前提下,根据法域的区别,可能由应用商店,政府,第三方验证供应商之间形成多层分工,操作终端和浏览器维度或可提供技术支撑。

这意味着,出海企业在合规设计和合同安排中,需要明确:

在某一市场是自建年龄保障方案,还是依赖应用商店或政府/第三方工具;

在隐私政策与用户条款中,如何说明不同主体对年龄验证结果的责任分配与投诉路径。

(四)法域调试点三:敏感内容场景的“加压阀”

最后一个关键差异点是对敏感内容的监管强度,同时,亦要注意付费、打赏等涉及财务风险场景。

一方面,就特殊内容,例如成人性内容与色情需要加强验证强度:多国博彩监管机构要求博彩运营商在反洗钱和负责任博彩义务下实施强KYC/年龄验证,未成年人参与将产生监管与刑事风险;DSA和英国Online Safety Act均要求对于自残、极端减肥和暴力内容等可能严重影响未成年人身心健康的内容进行专项风险评估和缓解,对平台提出更高的检测与干预要求。

另一方面,部分重视内容安全的法域的刑事风险亦需注意:在沙特和阿联酋,涉及儿童色情或性剥削的在线行为不仅引发数据保护责任,更直接触发刑事处罚,平台如未采取合理技术与管理措施予以阻断,可能被认为未尽应有注意义务(sdaia.gov.sa)[47]。

因此,在进行业务设计和内部政策制定时,企业应针对敏感内容场景设计一套“内容风险×年龄分群×法域要求”的内控矩阵,在欧盟、英国、美国、澳大利亚、中东等高要求或高风险法域上叠加更严格的年龄保障、审核与取证措施。

综上,从实践看,更可行的路径并非“一国一策”,而是先在集团层面建立相对清晰的产品分类、年龄分群与敏感内容识别框架,以此作为内部共识的起点;再以欧盟DSA、英国Online Safety Act、新加坡PDPC指引等相对成熟、要求较高的制度作为“安全上限”,沉淀一套可在多法域复用的基础能力;最后,围绕年龄定义、责任分配与敏感内容边界等关键调试点,根据目标市场的具体规则和执法取向进行适度收放,并通过DPIA、流程文档和合同安排将这些取舍固化下来。

四、结语:从“是否合规”到“如何守护”

综合前述分析可以看到,国际监管在未成年人在线保护上的共识,正在从“是否应当实施年龄验证”转向一个更为现实、也更具挑战性的问题:在什么场景下需要年龄保障,由谁承担责任,以及这种保障应当做到多深,才能既真正保护未成年人,又不过度牺牲隐私、表达自由与正常的数字体验。

这一转向,本身并非对技术或企业的不信任,而是对未成年人这一群体脆弱性的正视。在网络与 AI技术不断降低内容获取门槛、放大情绪与行为反馈的背景下,单纯依赖用户自我声明或事后补救,已难以回应社会对未成年人安全的基本期待。年龄保障机制,正是在这样的现实语境中,从“可选合规手段”逐步被推向“前置治理能力”。

对中国出海互联网企业而言,这一变化既是合规压力,也是一道价值命题。真正重要的,并不在于是否采用某一种最新的年龄识别技术,而在于企业是否愿意并且能够,围绕不同年龄段用户的真实风险,构建一套可持续、可解释、也能被监管与公众理解的保护逻辑。这种逻辑,往往并不体现在冰冷的条款中,而是体现在产品设计的细节里——默认更安全的设置、对风险更温和但明确的提示、对未成年人个人信息更克制的使用,以及在关键节点让监护人真正“看得见、管得住”。

正如一些大型平台在面向儿童和青少年时所采用的安全提示那样,未成年人保护并不一定意味着排斥或恐吓,而可以是清晰、友善且尊重用户的引导。这类设计背后体现的,并不是对监管的被动回应,而是一种对“人”的理解:理解未成年人尚在成长中的判断力,也理解家庭与社会对平台所寄予的信任。

从这个意义上看,年龄验证并非企业被迫承受的合规成本,而是数字社会走向成熟过程中的一部分努力与进步。当企业能够在不同市场中,为未成年用户提供相对一致、可证明、可审计的安全与隐私保护水位,其所建立的,不仅是对法律要求的回应,更是一种可信形象的长期积累——也是对“下一代应当拥有怎样的网络环境”这一问题的具体回答。

[注]

[1]澳大利亚:Online Safety Amendment (Social Media Minimum Age) Bill 2024, https://www.aph.gov.au/Parliamentary_Business/Bills_Legislation/Bills_Search_Results/Result?bId=r7284&utm.

[2]Norway Moves Forward with Age Limit for Social Media,

https://www.regjeringen.no/en/whats-new/norway-moves-forward-with-age-limit-for-social-media/id3108682/?utm

JAMES BROOKS, Denmark plans to severely restrict social media use for young people, https://apnews.com/article/denmark-social-media-ban-australia-1e96a3df3276cc2033a6f04effb89f51, AP News;

KUALA LUMPUR, Malaysia says it plans to ban social media for under-16s from 2026.

https://www.reuters.com/world/asia-pacific/malaysia-says-it-plans-ban-social-media-under-16s-2026-2025-11-24/?utm , Reuters(最后访问日期:2025年12月24日)。

[3]Hadas Gold, More Families Sue Character.AI Developer, Alleging App Played a Role in Teens’ Suicide and Suicide Attempt, https://www.cnn.com/2025/09/16/tech/character-ai-developer-lawsuit-teens-suicide-and-suicide-attempt (最后访问日期:2025年12月8日); Garcia v. Character Technologies, Inc., 6:24-cv-01903, (M.D. Fla.).

[4]英国:ICO: “Age Assurance for the Children’s Code”, https://ico.org.uk/about-the-ico/what-we-do/information-commissioners-opinions/age-assurance-for-the-children-s-code/ .(最后访问日期:2025年12月8日)。

[5]欧盟:European Commission: “Communication from the Commission – Guidelines on Measures to Ensure a High Level of Privacy, Safety and Security for Minors Online, Pursuant to Article 28(4) of Regulation (EU) 2022/2065”, https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=OJ:C_202505519. (最后访问日期:2025年12月8日)。

[6]Id.

[7]澳大利亚: Australia’s Digital ID system: Social Media Minimum Age Verification law and Digital ID, https://www.digitalidsystem.gov.au/news/social-media-minimum-age-verification-law-and-digital-id?utm. (最后访问日期:2025年12月24日)。

[8]Jessica Galissaire, Mind the Gap: Age Assurance and the Limits of Enforcement under EU Law, Strengthening the Digital Public Sphere and Platform Regulation, Interface, https://www.interface-eu.org/publications/age-assurance-gap?utm. (最后访问日期:2025年12月7日)。

[9]欧盟《视听媒体服务指令》(《AVMS指令》)(2018)第6a条:“1.成员国应采取适当措施,确保在其管辖范围内由媒体服务提供商提供的、可能损害未成年人身心或道德发展的视听媒体服务,仅以确保未成年人通常不会听到或看到的方式提供。此类措施可包括选择播出时间、使用年龄验证工具或其他技术措施。这些措施应与节目可能造成的危害程度相称。

对于无端暴力和色情等最具危害性的内容,将采取最严格的措施。

2.根据第1款,媒体服务提供商收集或以其他方式生成的未成年人个人数据不得用于商业目的,例如直接营销、用户画像和行为定向广告。”

[10]美国《儿童在线隐私保护法》第312.5(b)条。

[11]美国《加州消费者隐私法案》(CCPA/CPRA).https://leginfo.legislature.ca.gov/faces/codes_displayText.xhtml?division=3.&part=4.&lawCode=CIV&title=1.81.5 ;美国《科罗拉多州隐私法案》(CPA)https://www.consumerprivacyact.com/colorado-privacy-act-cpa/;美国《康涅狄格州数据隐私法案》(CTDPA)https://www.consumerprivacyact.com/connecticut-consumer-privacy-law/.

[12]美国《科罗拉多州隐私法》(Colorado Privacy Act), Colo.Rev. Stat. § 6-1-1308(6)(关于处理13–15岁未成年人定向广告需经明确同意);

美国《康涅狄格州数据隐私法》(Connecticut Data Privacy Act), Public Act 22-15, § 6(a)(1)(关于13–16岁未成年人定向广告的 opt-in要求);

美国《加州适龄设计规范法案(AADC)》(California Age-Appropriate Design Code Act), Cal. Civ. Code § 1798.99.28(a)(5)(关于“默认高隐私设置”);

美国《科罗拉多州隐私法》(Colorado Privacy Act), Colo. Rev. Stat. § 6-1-1308(7);Connecticut Data Privacy Act § 6(b)(关于敏感数据处理需取得“积极授权”)。

[13]美国纽约州《禁止向儿童进行成瘾性信息推送法案》(SAFE for Kids Act),要求对未成年人禁用”addictive feed”并限制夜间通知和算法推荐;

美国田纳西州《保护儿童免受社交媒体侵害法案》(Protecting Children from Social Media Act) Tenn. Code Ann. §§ 47-18-5701 – 5706 (要求这些社交媒体公司允许父母查看隐私设置、设置每日使用时间限制,并设定未成年人无法访问账户的时间段);

美国密西西比州《沃克·蒙哥马利儿童在线保护法案》(Walker Montgomery Protecting Children Online Act),Miss. Code Ann. §§ 45-38-1–45-38-13(要求未成年人在创建社交媒体账户前必须进行年龄验证并获得父母同意);

美国《儿童远离社交媒体法案》(Kids Off Social Media Act),提案禁止13岁以下用户使用社交媒体,并禁止对未满17岁者使用个性化推荐系统。

[14]NetChoice, LLC v. Griffin, No. 5:2023cv05105 - Document 44 (W.D. Ark. 2023).

[15]NetChoice v. Paxton, No. 21-51178 (5th Cir. 2024).

[16]Free Speech Coalition v. Paxton, 606 U.S. (5th Cir. 2025).

[17]Cho, Clare Y., Identifying Minors Online, Congress.gov., https://www.congress.gov/crs-product/R47884#citation (最后访问日期:2025年12月7日)。

[18]美国德州《应用商店问责法案》(Texas S.B. 2420, App Store Accountability Act),Texas Business & Commerce Code ch. 121,即将于2026年1月1日生效,但面临临时禁令的法律挑战;

美国路易斯安那州《应用商店问责法案》(Louisiana H.B. 570, App Store Accountability Law );

美国犹他州《应用商店问责法案》(Utah S.B. 142, App Store Accountability Act),Utah Code Ann. tit. 13, ch. 76。

[19]法国新的《SREN法》规定在线提供色情内容的网站发布商和平台必须实施强有力的年龄验证系统,以防止未成年人访问此类内容。

[20]参见ARCOM,“确定向公众提供色情内容的特定在线公共通信服务及视频分享平台,其访问所设年龄验证系统适用的最低技术要求参考标准” (Référentiel déterminant les exigences techniques minimales applicables aux systèmes de vérification de l’âge mis en place pour l’accès à certains services de communication au public en ligne et aux plateformes de partage de vidéos qui mettent à disposition du public des contenus pornographiques),https://www.arcom.fr/sites/default/files/2024-10/Arcom-Referentiel-technique-sur-la-verification-de-age-pour-la-protection-des-mineurs-contre-la-pornographie-en-ligne.pdf,(最后访问日期:2025年12月13日)。

参见CNIL,Online age verification: balancing privacy and the protection of minors,https://www.cnil.fr/en/online-age-verification-balancing-privacy-and-protection-minors(最后访问日期:2025年12月13日)。

[21]Patrice-Emmanuel SCHMITZ, A crucial, EUPL covered project, to follow..., EUPL, https://interoperable-europe.ec.europa.eu/collection/eupl/news/eu-age-verification-solution (最后访问日期:2025年12月8日)。

[22]Katelyn Ringrose, David Sullivan, Basia Walczak & Melanie Selvadurai, Mind the gap: Understanding age verification and assurance, IAPP, https://iapp.org/news/a/mind-the-gap-understanding-age-verification-and-assurance?utm (最后访问日期:2025年12月7日)。

[23]参见前注15, Cho, Clare Y.

[24]参见前注2,英国Ofcom.

[25]参见前注4,欧盟European Commission.

[26]儿童向产品(child-directed services):完全为儿童设计的内容或服务,如儿童动画平台、儿童教育App、玩具配套App等。这类产品通常在产品定位上即将儿童作为主要服务对象,各法域多将其纳入最严格的未成年人保护框架。例如COPPA在判断“网上服务是否面向儿童”时,就将内容主题、视觉风格和广告定位等作为关键因素。

[27]混合受众产品(mixed-audience services):面向泛用户群体,但青年和未成年人高度活跃,例如:主流社交平台、短视频与直播平台、游戏平台、带评论和私信功能的工具类或学习类App。欧盟DSA指南和新加坡PDPC儿童数据指引均强调,只要服务“可能被未成年人访问(likely to be accessed by minors/children)”,即应履行相应的年龄保障和儿童保护义务。

[28]成人向产品(adult-only services):色情网站、成人直播、赌博、约会和某些成人漫画/网文服务等。法国、英国和多个美国州都将成人内容网站作为强制年龄验证立法的优先对象,要求接入强度较高的年龄验证方案。

[29]参见前注4,欧盟European Commission。

[30]各国法规明确区分的是儿童和未成年人,B、C分组仅基于行业实践和监管指南等文件,结合不同年龄段的成熟度情况进行进一步区分,实务中亦可根据自身情况整合B、C组为一组趋严处理。

[31]参见英国ICO《儿童适龄设计规范》(Age-Appropriate Design Code),第7条“高隐私默认 (High privacy by default)”要求儿童用户默认采用最高隐私保护设置、第10条“地理位置”要求默认关闭位置分享功能,https://ico.org.uk/for-organisations/uk-gdpr-guidance-and-resources/childrens-information/childrens-code-guidance-and-resources/age-appropriate-design-a-code-of-practice-for-online-services/.(最后访问日期:2025年12月10日)。

[32]参见欧盟:“Guidelines on measures to ensure a high level of privacy, safety and security for minors online, pursuant to Article 28(4) of Regulation (EU) 2022/2065”,第2条,https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=OJ:C_202505519#ntc1-C_202505519EN.000101-E0001(最后访问日期:2025年12月10日);英国《在线安全法案》(Online Safety Act),第6(7)条。

[33]参见Ash, J., Gordon, R., & Mills, S., Between Gaming and Gambling: Children, Young People, and Paid Reward Systems in Games, Newcastle/Loughborough University.

[34]参见欧盟 European Commission,“未成年人保护指南“(Commission publishes guidelines on the protection of minors),https://digital-strategy.ec.europa.eu/en/library/commission-publishes-guidelines-protection-minors(最后访问日期:2025年12月 10日);英国Ofcom, 儿童保护行为准则Protection of Children Code of Practice for user-to-user services。

[35]需符合适用法域民事法律规定。

[36]参见欧盟European Commission,“未成年人保护指南“(Commission publishes guidelines on the protection of minors);Mamtaj Akter, Amy Godfrey, Jess Kropczynski, Heather Lipford & Pamela Wisniewski, From Parental Control to Joint Family Oversight: Can Parents and Teens Manage Mobile Online Safety andPrivacy as Equals?, Cornell University, p.575.

[37]参见美国NTIA,“FACT SHEET: Biden Administration Outlines Industry Guidance and Family Resources to Support Youth Safety Online“,https://www.ntia.gov/other-publication/2024/fact-sheet-biden-administration-outlines-industry-guidance-and-family-resources-support-youth-safety(最后访问日期:2025年12月10日);英国Ofcom, Protection of Children Code of Practice for user-to-user services。

[38]参见美国NTIA:“Kids Online Health & Safety Report”,p28-31, https://www.ntia.gov/sites/default/files/reports/kids-online-health-safety/2024-kohs-report.pdf(最后访问日期:2025年12月10日);OECD:“Children in the Digital Environment: Guidelines for Online Platforms”。

[39]参见前注29。

[40]需符合适用法域民事法律规定。

[41]需符合适用法域民事法律规定。

[42]参见前注35。

[43]多数法域允许16–17岁在数据同意方面接近成年人,但在色情、赌博和极端暴力内容上,仍视为未成年人保护对象。欧盟议会2025年通过的关于社交媒体与AI聊天机器人的决议,建议将16岁以下限制访问,13–16岁须有家长同意,反映出对高龄未成年人的“过渡性保护”倾向。

[44]参见欧盟《数字服务法(DSA)》(Digital Services Act),第38条;欧盟《未成年人保护指南》(Commission publishes guidelines on the protection of minors)。

[45]参见前注29。

[46]例如,中国将14岁以下定义为儿童;GDPR 允许成员国在13–16岁之间设定数字同意年龄,参见前注4,欧盟European Commission。新加坡PDPC指引以13岁为关键分界,13–17岁仍被视为需要加强保护群体,DPC Singapore: “Advisory Guidelines on the PDPA for Children’s Personal Data in the Digital Environment”, at https://www.pdpc.gov.sg/guidelines-and-consultation/2024/03/advisory-guidelines-on-the-pdpa-for-childrens-personal-data-in-the-digital-environment (最后访问日期:2025年12月7日)。欧盟议会最新决议建议将社交媒体和AI聊天机器人的最低年龄统一为16岁,表明政治层面有提高保护年龄的趋势,News European Parliament: “New EU measures needed to make online services safer for minors”, at https://www.europarl.europa.eu/news/en/press-room/20251013IPR30892/new-eu-measures-needed-to-make-online-services-safer-for-minors (最后访问日期:2025年12月8日)。

[47]SDAIA:“Children and Incompetents’ Data Protection Policy“,at https://sdaia.gov.sa/en/SDAIA/about/ArchivesRegulationsAndPolicies/ChildrenAndIncompetentsDataProtectionPolicyEN.pdf.